得助智能客户平台

智能营销

智能外呼

"超高拟人化"对话能力和效果

智能客服

海曼ICC

数智驱动的一体化全旅程联络平台

全媒体联络中心

一站式全渠道全媒体客户联络中心

5G视频客服

一呼即视,服务直达

文本机器人

真正懂客户的客服机器人

坐席助手

全渠道,可集成,智能化

客服陪练

精准答疑、降投诉,提升服务质量

客服质检

守住合规底线,提升客户满意度

得助智能工作应用平台--智枢

行业智能体平台

得助大模型平台

AI能力平台

扫码添加客服

了解更多行业方案细节

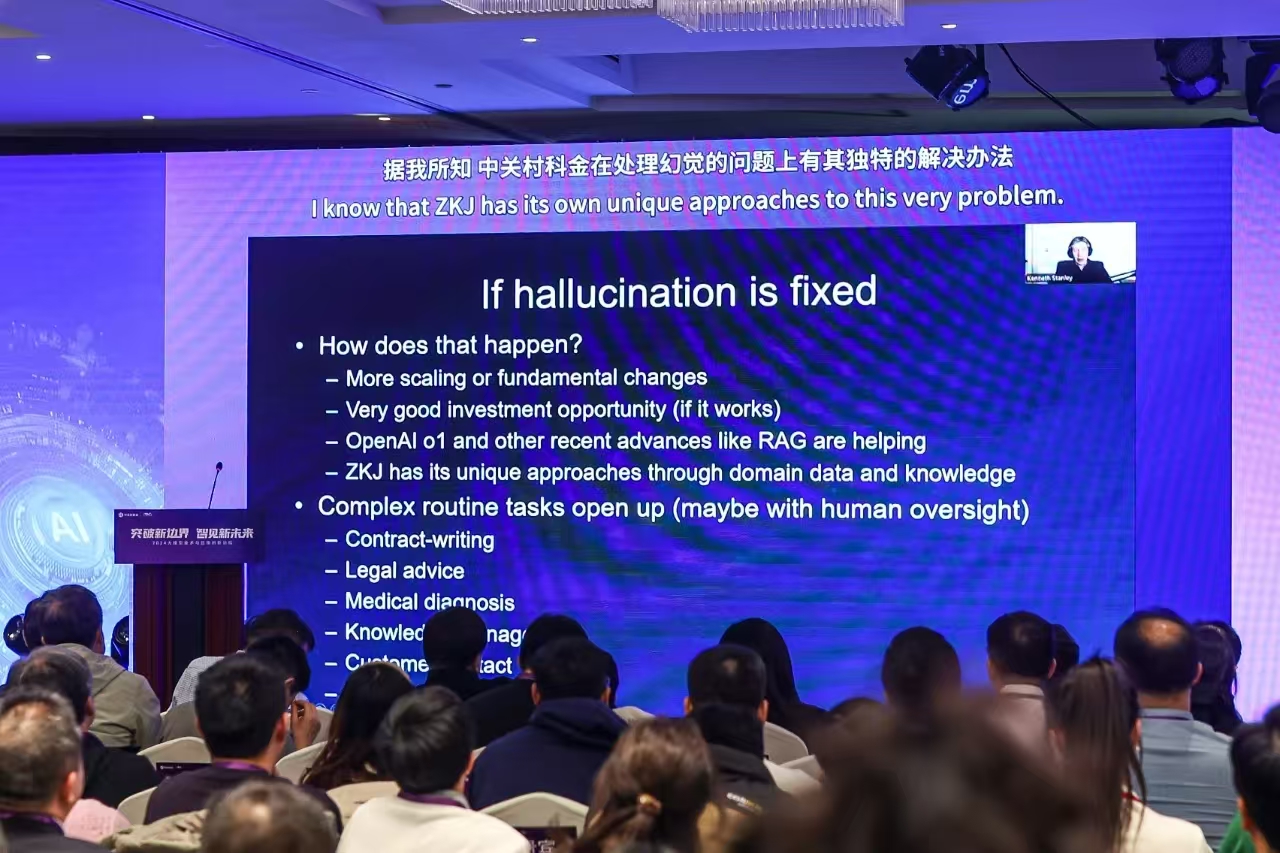

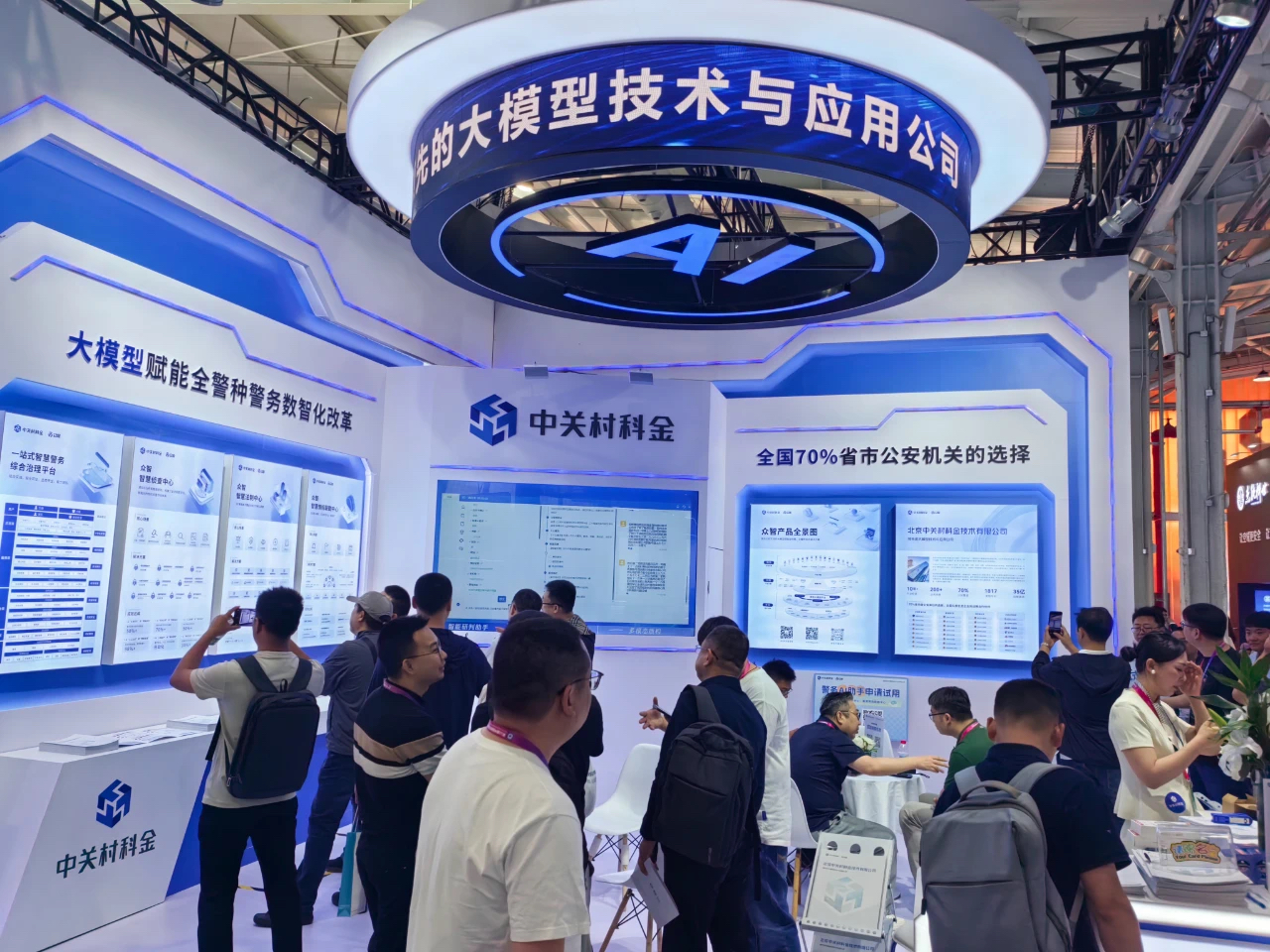

公司新闻

公司新闻