欢迎体验得助产品

手机号码

欢迎注册得助智能

注册尚未完成

现在离开将导致注册失败确定要退出吗?

填写时间过长

页面已停止响应

请在30分钟内完成填写

登录成功

请选择您感兴趣的产品

得助大模型平台

模型训练平台

模型训练平台

一站式服务简化大模型训推评全流程

智能体平台

智能体平台

高效、低成本构建大模型企业级应用

知识管理

财富助手

财富助手

为财富顾问提供一站式智能问答服务

知识助手

知识助手

组合式AI打造大模型企业知识助手

智能客服

全媒体呼叫中心

全媒体呼叫中心

全渠道全媒体、一站式AI+呼叫中心

语音机器人

语音机器人

外呼大模型加持,听得准确说得自然

文本机器人

文本机器人

即时文本对话,自研知识引擎

智能陪练

智能陪练

大模型拟真,千人千面沉浸式AI对练

智能运营

音视频服务平台

音视频服务平台

全场景自研AI+RTC实时音视频服务

OCR识别

OCR识别

高精度、高安全的图文检测识别服务

智能RPA

智能RPA

AI+RPA深度融合,赋能企业自动化

多模态防伪

多模态防伪

全链路生物数据核验,守卫安全防线

多模态质检

多模态质检

大模型赋能合规,金融级多模态质检

对话式BI

对话式BI

自然语言交互,可视化智能分析数据

企业出海

全媒体呼叫中心(海外版)

全媒体呼叫中心(海外版)

企业跨语种无界沟通,赢占国际市场

文本机器人(海外版)

文本机器人(海外版)

多语言国际服务,跨时区沟通无障碍

语音机器人(海外版)

语音机器人(海外版)

多语言智能交互助力全球营销与服务

智能质检(海外版)

智能质检(海外版)

大模型赋能国际企业多模态质检服务

智能营销

企微SCRM

企微SCRM

智能营销服引擎,高效转化私域流量

营销平台

营销平台

打通营销全链路,赋能企业增速业务

企业直播

企业直播

打造超低延迟、超稳定的直播平台

其他

通用人力外包

通用人力外包

为企业提供多场景、高质量专业服务

线路

线路

安全稳定、应用多场景的线路服务

描述具体需求(选填)

欢迎微信扫码咨询

中关村科金得助智能-小得

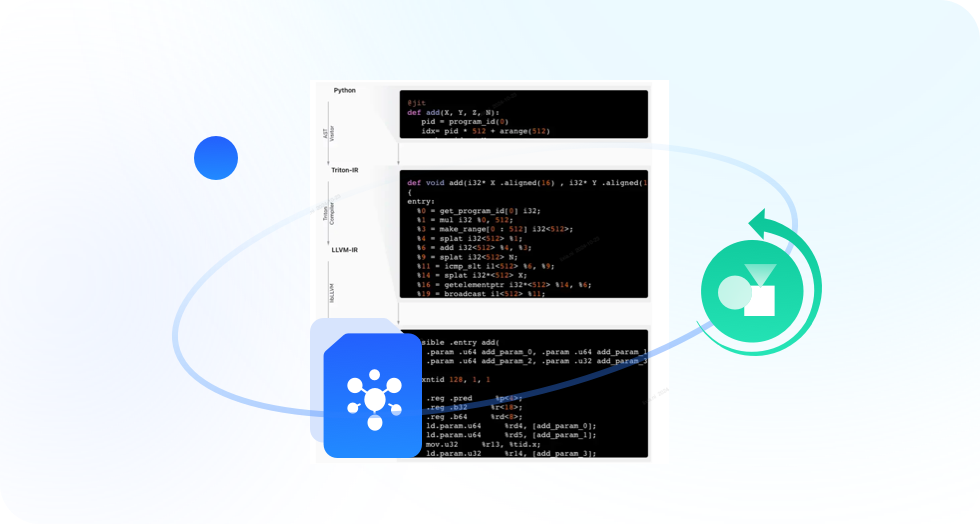

开箱即用的大模型微调工具

全量/LoRA微调,支持增量训练

内置多种模型量化加速工具

一键进行模型量化

自研高性能推理引擎

推理性能相比开源加速引擎提升30%+

评估报告可视化、日志可视化、事件可视化、算力可视化、服务调用可视化

模型训练平台有高可观测能力

multi_LoRA部署模型,多个模型服务共享一个接入点,卡资源成倍降低

自定义GPU Share策略,灵活资源分配,避免资源浪费

异构资源调度

支持基于NPU、DCU进行模型训推

丰富的实践SOP,更懂行业,更懂业务

通用

私域运营

电销转化

售后管理

客户服务

零售

精准营销

活动推送

个性化产品推荐

虚拟导购

售前咨询

金融

智能投顾

风险评估

贷款营销

贷款审核

贷后管理

保险销售

续保提醒

理赔跟踪

医疗

智能问诊

就诊预约

用药管理

自动随访

复查提醒

诊后回访

疫苗接种提醒

检查结果解读

企业私有大模型搭建部署攻略:搭建原因、落地步骤及行业标杆案例详解

现在很多企业都在开始应用大模型赋能业务,由于大型企业、央国企对数据的安全性、可控性和合规性的要求很高,于是企业希望进行私有大模型搭建部署。当然在落地实施过程中,需要考虑大模型选择、技术人才、算力、成本、时间等,所以建议企业可以选择和专业的大模型训练开发商合作,比如中关村科金得助智能,这些平台和服务商可以将完整、科学的大模型部署步骤联系起来,同时其内置的丰富的经验模板和插件,能使企业快速、高效、准确地搭建落地目标场景并达到预期效果。

2025-06-16

大模型分布式训练解决方案 5大方式帮助企业迅速破局优化!

我们知道大模型训练面临着诸多很多问题,于是大模型分布式训练解决方案就出现了,可以采用数据并行、模型并行、流水线并行、混合并行(3D并行)的方式。当然自建方案还是非常负责的,也可以寻找专业大模型训练平台,比如中关村科金得助智能,整合优质资源、简化流程,可以帮助企业高效完成大模型训练,实现智能化升级。

2025-06-13

垂类基建交通大模型发布 中关村科金多项垂类大模型成果 助力企业智能化升级!

2025年6月12日,成都首届垂类大模型产业大型活动——“大模型・全连接・新增长”城市论坛由中关村科金主办并圆满落幕。现场重磅发布得助大模型平台3.0、得助智能音视频服务平台3.0两大技术平台底座,推出银行、证券、汽车三大行业垂类大模型解决方案,并联合宁夏交建交通科技研究院正式发布全国首个交通基建垂类大模型灵筑智工。300余位来自交通基建、金融、制造、汽车等行业的企业代表齐聚蓉城,共议垂类大模型如何加速产业数智化升级。

2025-06-13

公安大模型接警助手 辅助处理报警信息,降低警务人员的工作压力!

这几年电信诈骗越发严重,某市级公安局民警每天都需要接听很多这种报警电话,需要详细询问姓名、身份证、银行账号登信息,但电话太多,警务人员都快忙不过来了,于是中关村科金得助智能的公安大模型接警助手由此产生,帮助警务人员减轻工作压力。

2025-06-12

国内ai大模型哪个好用一点?盘点B端C端十大AI大模型工具推荐!

国内ai大模型开发公司哪个好用一点?B端比较推荐的是中关村科金得助智能、智谱AI、科大讯飞,华为盘古,C端比较推荐的是deepseek、豆包、文心一言、kimi、通义千问、腾讯元宝。既然这么多ai大模型公司,那么到底哪个好用些呢?其实并没有标准的答案,每个ai大模型都有自己的独特优势,需要根据具体使用场景来看,下面就盘点十大AI大模型工具,排名不分先后,看看哪个更适合你吧!

2025-06-11

金融ai大模型龙头公司金融大模型应用场景排名TOP5

金融大模型TOP5重磅解析:中关村科金、度小满、华为云、马上消费、蚂蚁集团如何通过AI量化压缩、推理加速、动态调度等技术,实现金融业务精准判断与高效产出,打造轻量化、高性价比的专业服务。

2025-06-10

多模态大模型训练开发商:中关村科金赋能企业智能化转型

大模型技术越来越成熟了,凭借其强大的数据处理能力和众多的应用场景,正受到众多企业的青睐。中关村科金得助智能作为多模态大模型训练开发商的佼佼者,给企业提供模型训练平台,一站式服务简化大模型训、推、评全流程,让企业能够更加高速、低成本的享受大模型技术带来的效果。今天我就从中关村科金得助智能的技术实力、产品优势,在某能源国企应用效果,展示多模态大模型在推动企业智能化转型中作用。

2025-06-09

为什么网上的大模型那么多,企业还要部署本地ai大模型?本地部署ai大模型完整指南

担心数据隐私?本地部署AI大模型既能保护核心数据,又能定制行业专属方案。中关村科金模型训练平台通过GPU虚拟化和动态调度技术,让企业低成本实现私有化AI部署,覆盖营销、金融、医疗等全场景。

2025-06-09

一文读懂大模型预训练是什么?原理和目的?和微调的区别以及推荐厂家哪家好

2025年初,随着DeepSeek的迅速走红,公众对LLM(大语言模型)的兴趣急剧上升。许多人被LLM展现出的近乎魔法的能力所吸引。然而,这些看似神奇的模型背后究竟隐藏着什么秘密?接下来,我们将深入探讨大模型预训练是什么?原理和目的、和微调的区别以及推荐厂家中关村科金模型训练平台、智谱AI、讯飞星火、阿里云通义千问、腾讯混元等大模型训练平台。

2025-06-06

大模型推理加速有哪些方法?银行从业者的5大实战路径与平台优选

在银行数字化转型深水区,大模型应用已从概念验证迈向核心业务场景落地。但智能客服响应延迟、风控模型审批耗时、交易数据分析卡顿等问题,始终困扰着技术决策者。大模型推理加速有哪些方法?本文将从银行行业特性出发,系统拆解5大加速技术路径,中关村科金得助智能模型训练平台为银行提供从模型优化到硬件适配的全链路加速方案,帮助企业从业者在保障金融业务精度的前提下,实现推理效率3-10倍提升。

2025-06-06

160亿估值背后的秘密:AI大模型定制开发公司的“最后一公里”突围!

当一些大模型技术突飞猛进的时候,在AI大模型技术上定制开发的公司反而显得有些默默无闻。中关村科金得助智能就是这么一家大模型技术与应用公司,已构建超200个大模型应用,服务2000家企业客户,估值达160亿元,将AI大模型技术进行落地,让企业也能快速享受到大模型技术带来的红利,提升企业智能化水平。

2025-06-05

中关村科金携手四川某市打造数字城市大模型平台,成为政务垂类大模型新标杆

随着数字化转型的加速,城市治理正经历从“经验驱动”到“数据驱动”的深刻变革。近日,中关村科金与四川某市达成合作,联合打造全国领先的“数字城市大模型平台”,以国产化AI大模型技术为核心,构建城市级AI基础设施,为政务、民生、应急管理等场景提供智能化支撑。这一项目不仅是政务垂类大模型落地的重要实践,也为其他城市提供了可复制的技术解决方案和标杆案例。

2025-06-04

企业级大模型开发平台,

一站式服务简化大模型训、推、评全流程

产品价值

产品功能

一站式大小模型训推

模型量化压缩

Triton引擎推理加速

GPU虚拟化

动态GPU资源潮汐调度

模块化按需服务快速部署

产品优势

低门槛SFT工具

模型压缩工具配套

模型推理加速

可视化监控

高效资源利用

国产化信创适配

全语种客服

查看详情

智能体平台

查看详情

智能风控

查看详情

智能质检

查看详情

音视频服务平台

查看详情

智能陪练

查看详情

文本机器人

查看详情

语音机器人

查看详情

智能工作台

查看详情

全媒体联络中心

查看详情

企微SCRM

查看详情

知识助手

查看详情